Compositing

¿Qué es?

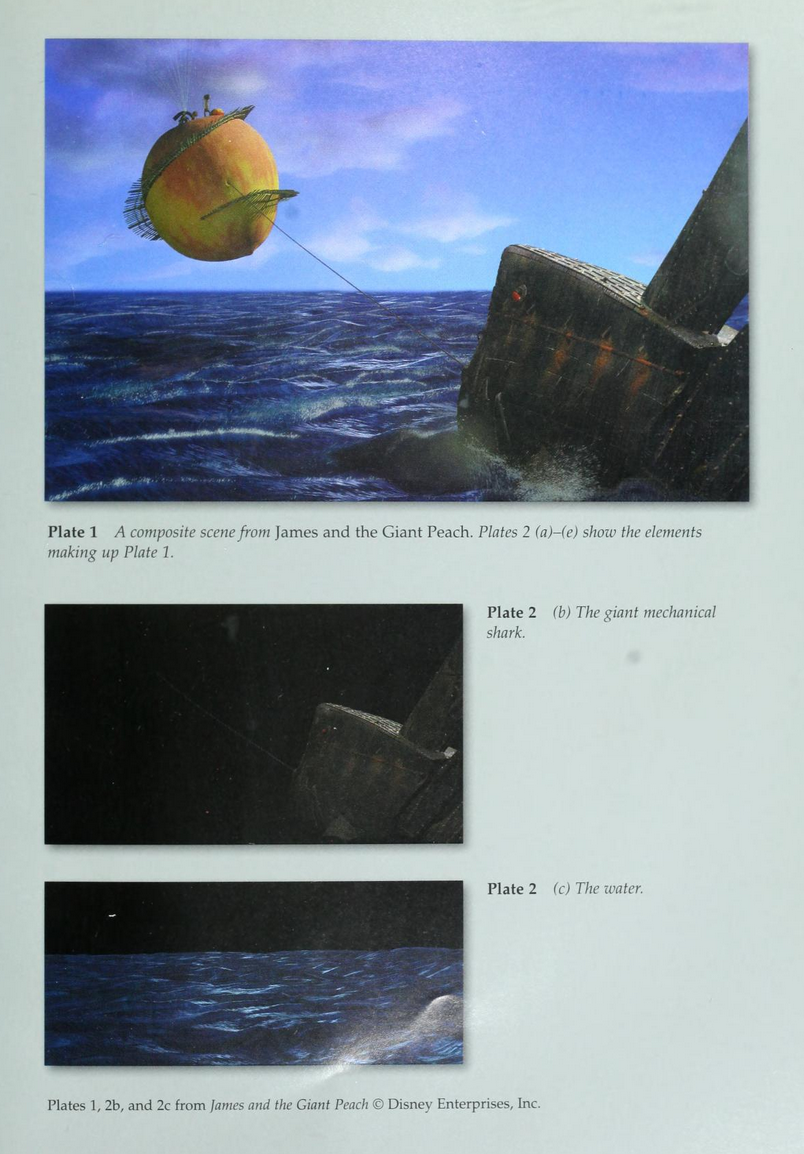

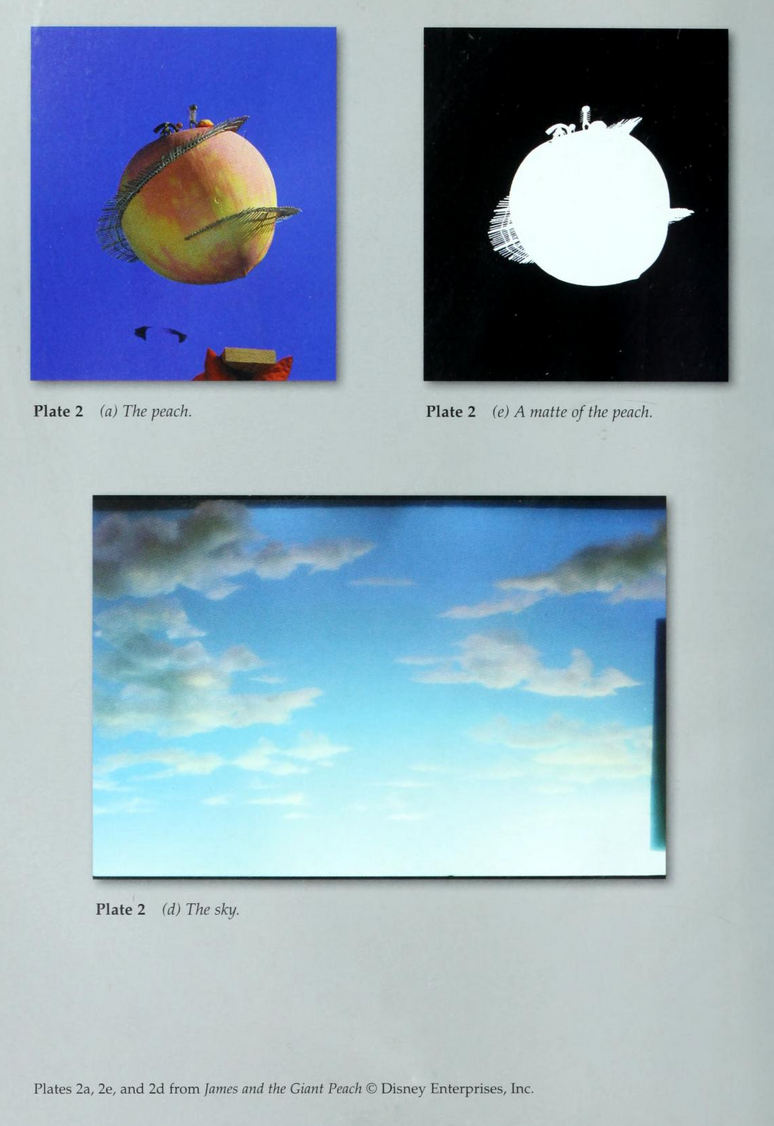

En The Art and Science of Digital Compositing, Ron Brinkmann define el compositing como el proceso de combinar imágenes de múltiples fuentes en una sola imagen final coherente.

Consiste en integrar elementos visuales, como personajes, fondos, efectos y simulaciones, para que parezcan existir en el mismo espacio, con iluminación, color y profundidad consistentes.

Los elementos visuales pueden provenir de:

- Material filmado en cámara (actores, objetos, escenarios)

- Renders 3D (personajes, props, entornos, simulación)

- Simulación digital (humo, fuego, fluidos, partículas)

- Matte paintings y fondos digitales

- Máscaras (masks) y mattes (alpha, ID masks)

- Elementos gráficos o motion design

En producción profesional, el render es la materia prima para componer imágenes.

¿Para qué se usa?

Se usa para construir la imagen final en producción audiovisual.

El compositing permite:

- Integrar renders 3D sobre fondos reales o digitales

- Ajustar color y luz para coherencia visual

- Añadir efectos como humo, fuego, glow o profundidad de campo

- Corregir errores de render sin re-renderizar

- Combinar múltiples pases (diffuse, specular, shadow, etc.)

¿Cómo se lleva a cabo?

En flujos de trabajo profesionales, el compositing comienza incluso antes de abrir el software de composición. El control sobre la imagen final depende de cuánto se haya separado la información visual desde el origen.

En live action, la imagen se captura físicamente en cámara. Por ello, la separación de información puede comenzar desde el set, mediante decisiones físicas como el uso de pantalla verde, marcadores de tracking, elementos removibles o capturas adicionales como clean plates y referencias de iluminación. Estas decisiones facilitan el aislamiento de ciertos elementos más adelante.

También puede producirse una separación durante la captura misma, por ejemplo mediante exposiciones múltiples, fotografía HDR o captura de datos espaciales que permitan reconstruir iluminación y profundidad en postproducción. Finalmente, cuando la imagen ya ha sido grabada, es posible extraer información mediante técnicas como rotoscoping, keying y generación de máscaras (mattes).

En Maya, por ejemplo, la escena se prepara exportando distintos render passes o AOVs (Arbitrary Output Variables) que separan información como iluminación, sombras o profundidad, permitiendo control fino en postproducción sin necesidad de re-renderizar.

En ambos casos, ya sea en 3D o en live action, el principio es el mismo: evitar depender de una imagen completamente “horneada” y trabajar en cambio con información que pueda controlarse y ajustarse durante el proceso de integración final.

Software como Nuke, After Effects o el Compositor de Blender son las herramientas donde estos datos se integran y ajustan hasta lograr una imagen final consistente.

- Nuke → Node-based compositing

- After Effects → Capas, máscaras, blending modes

- Blender → Compositor (node-based)

- Maya → Render passes para comp

- Unreal Engine → Post Process / compositing externo

Relacionado con

Keying, AOV, Matte, Mask, Alpha Channel, Rotoscoping, Render Passes, Color Correction